L'histoire de l'Intelligence Artificielle

L’Intelligence Artificielle est née dans les années 50, où presque simultanément, plusieurs travaux de recherche sont réalisés, notamment aux Etats-Unis. Retraçons ensemble l’histoire de l’Intelligence Artificielle à travers les points clefs de son évolution.

Années 50 : franchissement de plusieurs étapes

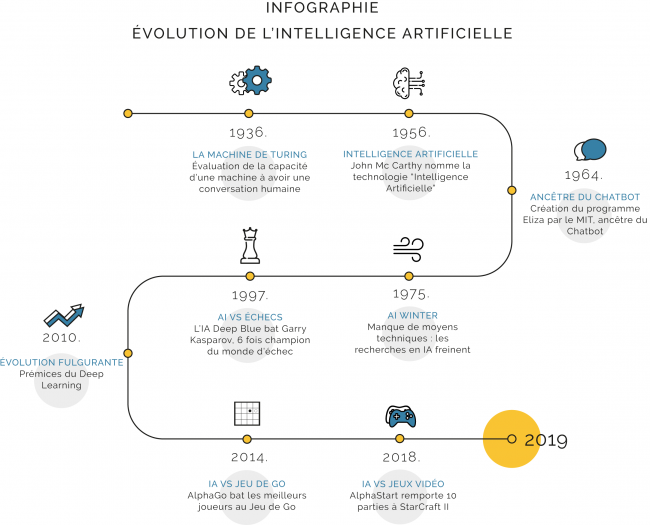

• 1950 – Les travaux de Turing (Machine de Turing) : Alan Turing, mathématicien, développe et conceptualise les prémisses de l’Intelligence Artificielle. Grâce à des jeux d’imitations, il mathématise l’intelligence humaine. Il réalise alors son célèbre test de Turing, qui évalue la capacité d’une machine à entretenir une conversation humaine.

Simultanément, Claude Shannon développe la théorie de l’Information à l’Université de Manchester. Elle lui permet de mathématiser les parties d’échec et de calculer les meilleurs mouvements à réaliser pour gagner une partie.

• 1956 – Un moment clef dans l’histoire de l’Intelligence Artificielle. John Mc Carthy organise la célèbre conférence à l’Université de Dartmouth, accompagné de ses confrères Alan Turing, Newell, Samuel, Simon et Minski. Il donne alors son nom à l’Intelligence Artificielle. Il définit également le but de cette technologie comme étant de modéliser l’intelligence humaine. L’Intelligence Artificielle devient alors une discipline académique à part entière.

• 1958 – John McCarty créé le langage LISP, spécialisé dans la programmation d’Intelligence Artificielle. Il le développe au MIT.

• 1959 – Le chercheur et informaticien A. Samuel évoque pour la première fois la notion de « Machine Learning ». Les scientifiques se rendent compte qu’il faut donner l’ensemble des informations indispensables à la machine pour qu’elle puisse « comprendre » son environnement. Ainsi, il faut apprendre à l’IA les conditions sociales basiques, que tous les humains connaissent. Par exemple : « si l’on coupe un morceau de beurre en deux, on obtient deux morceaux de beurre, mais si l’on coupe une table en deux, on n’obtient pas deux tables ». C’est le début du Machine Learning.

Progrès de l'Intelligence Artificielle

• 1964 – Création de ELIZA, un programme informatique développé par le MIT, ancêtre du chatbot tel que nous le connaissons aujourd’hui.

• 1967 – Grenblatt, chercheur au MIT, développe le premier programme automatique au jeu d’échec pouvant vaincre des joueurs de niveau moyen.

• 1971 – Développement du robot SHRDLU par Winograd au MIT, logiciel qui permet de réaliser des dialogues et des jeux de questions-réponses entre IA et humain.

• 1975 – « AI Winter » : les recherches en IA freines. Le manque de moyen technique ne permet pas de réaliser des modèles suffisamment puissants pour atteindre les résultats attendus.

• 1997 – Deep Blue, créé par IBM, bat Garry Kasparov, alors six fois champion du monde d’échec. Ce moment est considéré comme un moment historique dans le développement de la technologie de l’Intelligence Artificielle. Elle est en mesure d’être plus opérationnelle et intelligente que les humains.

• Les années 2000 – C’est le début de l’ère numérique. La démocratisation des ordinateurs, l’arrivée des smartphones et autres technologies de ruptures permettent aux recherches et aux applications de l’Intelligence Artificielle de se développer et d’atteindre de plus en plus de secteurs d’activités

Intelligence Artificielle : où en est-on aujourd'hui ?

Aujourd’hui, on assiste à un réel développement de la technologie du Deep Learning. Cette évolution fulgurante a pu se développer de manière exponentielle ces dernières années grâce à plusieurs éléments notables :

- Grâce aux évolutions technologiques. Le Deep Learning s’est notamment développé grâce à la puissance actuelle des cartes graphiques, notamment via le constructeur NVidia.

- Grâce à l’accès en Open Source ou publique du Machine Learning (notamment pour et par la communauté scientifique et universitaire, qui a alors accès à des modèles de Machine Learning et peut ainsi avancer plus rapidement dans les recherches en Intelligence Artificielle).

- Grâce au développement de framework spécialisés en Deep Learning. Aujourd’hui, de nombreux framework sont accessibles aux initiés de l’Intelligence Artificielle. Ils ont pour but d’aider au développement d’Intelligences Artificielles basées sur les analyses prédictives, ou en d’autres termes, le Deep Learning. Parmi les plus connus, nous pouvons citer Tensorflow ou encore Caffe, deux frameworks qui ont aidés à démocratiser l’utilisation et le développement du Deep Learning.

• 2010 – Ruée vers l’Intelligence Artificielle

o Développement de nouveaux procédés d’Intelligence Artificielle : le Deep Learning.

o La data est au centre de ces nouvelles technologies.

o Les plus grandes entreprises ouvrent au fur et à mesure leur centre de recherche (Facebook avec FAIR dirigé par Yann Le Cun, de même qu’Amazone, Microsoft, Apple…).

• 2011 – L’Intelligence Artificielle Watson, développée par IBM, remporte le jeu télévisé américain Jéopardy!

• 2016 – AlphaGo, développé par DeepMind et rachetée par Google : une IA bat les meilleurs joueurs au jeu de Go.

• 2018 – AlphaStar, programme de Deep Learning également développé par DeepMind se lance dans les jeux vidéos, notamment avec StarCarft II, et remporte 10 parties consécutives contre un joueur professionnel. Cette réussite est considérée comme un exploit car le jeu implique d’être en mesure de gérer simultanément et en temps réel des dizaines d’unités de natures différentes.

• 2019 – Watson de IBM participe à un concours d’éloquence à l’occasion duquel elle débat contre une championne de débat américaine. Malgré le fait que Watson ne remporte pas la compétition, la sphère scientifique se réjouie de la performance de l’IA, qui reste très impressionnante. Ainsi, les IA sont en mesure de traiter le langage naturel et de l’utiliser lors d’une conversation. Parallèlement, l’IA de Facebook, Pluribus, réalise une première mondiale en battant 5 des meilleurs joueurs de Poker au monde simultanément dans une partie multi-joueurs.

L’Intelligence Artificielle a connu un développement complexe et semé d’embûches au cours des dernières décennies. Aujourd’hui, on assiste à un engouement autour de cette technologie, et on lui voit venir un véritable renouveau avec la technologie de pointe du Deep Learning.

Le mot de l'expert

On assiste aujourd’hui à un développement exponentiel de la technologie de l’IA. Beaucoup se questionnent sur les limites de cette technologie et on peut s’imaginer des scénarios catastrophes sur le devenir des IA.

Alors, à quand les robots-tueurs et les IA maléfiques?

« Nous sommes à la fois loin et proche de connaître des IA capables d’avoir l’intelligence nécessaire pour dominer l’espèce humaine.

Loin car même si les progrès en IA sont remarquables, nous n’avons pas encore de solution pour procurer à une IA une intelligence déductive capable de lui donner le sens commun. Et cette révolution pourrait prendre encore des décennies avant d’être découverte.

Mais nous en sommes aussi très proche car l’Informatique est une science très jeune et pourtant déjà révolutionnaire.

Il faut également différencier la capacité à produire des robots-tueurs du passage à l’acte. A titre comparatif de ce scénario catastrophe, nous détenons aujourd’hui l’arme nucléaire, cela ne nous empêche-t-il pas pourtant de vivre en même temps que ces armes de destruction massive ? Non, et plus encore, nous avons pu leur donner une utilité dans le domaine civil.

Je pense qu’il en serait de même avec l’IA, à un élément prêt : se procurer de l’uranium n’est pas à la porté de tout le monde, alors que développer un IA tueuse nécessitera uniquement 3 éléments :

– Un ordinateur

– Internet

– Et un peu de curiosité…

Pour relativiser, je tiens à dire que nous sommes encore loin d’obtenir des IA destructrices indépendamment de la volonté humaine, mais une fois la découverte scientifique réalisée, l’accessibilité à une telle informatique pourrait avoir des conséquences drastiques sur notre société. C’est pourquoi il est primordial, dans la course au développement de l’IA, d’intégrer dès maintenant et au plus profond des briques logicielles, une notion garante du bien commun : l’éthique. »

Christophe Renaudineau, CEO de Robank Hood.